Il y a quelques semaines, nos étudiants en Mastère 1 Big Data & Intelligence artificielle à Bordeaux se sont frottés au Machine Learning avec Cheickna Anguilet Sylla. Peut-être l’un des modules les plus pointus en termes théoriques, il permet, via certains grands principes mathématiques, de créer des modèles d’apprentissage automatique très concrets.

C’est parti pour un tour d’horizon du Machine Learning et des projets portés par les étudiants avec Cheickna, data scientist chez Dassault Systèmes et formateur Sup de Vinci.

Comment aborde-t-on l’apprentissage du Machine Learning avec des étudiants ?

Tout d’abord, j’ai quelques années de recul sur l’enseignement. J’ai commencé à donner des cours de soutien scolaire à des collégiens et lycéens, cela m’a permis d’être capable de vulgariser.

Concernant le Machine Learning, au tout début du module j’essaie de jauger le niveau global des élèves et de comprendre les différents parcours. Par exemple, on a besoin de bases sur de l’algèbre linéaire ou des probabilités. Je reviens dessus grâce à des cas concrets et les amène petit à petit vers les algorithmes.

Pour finaliser l’introduction, on voit ensemble les notions les plus importantes :

- C’est quoi un algorithme ?

- Les familles d’algorithme

- Les problèmes de dimensionnalité

- Comment évaluer un modèle ?

Dans un deuxième temps, je les lance sur des travaux pratiques pour développer des algorithmes de base avec Python « from scratch » sans utiliser les framework existants.

Lors de ces TP, on utilise les données de Data Set type IRIS ou TITANIC qui sont très pratiques pour une utilisation pédagogique et pour mettre en exergue les notions qu’on veut aborder.

De la théorie à la mise en pratique.

Une fois ces bases acquises, les étudiants doivent travailler dans les derniers jours de la semaine sur un projet avec des Data Sets qu’ils choisissent eux-mêmes. Par groupe, ils doivent :

- Choisir une API

- Traiter et présenter la donnée

- Faire un descriptif du data set

- Définir un but : « qu’est-ce qu’on veut prédire/apprendre ? »

- Choisir son modèle et savoir comment l’évaluer.

- Choix des frameworks sklearn, PyTorch etc.

Ils peuvent travailler sur un sujet qui les intéresse, soit par une accroche personnelle, soit parce que c’est lié à leur alternance. Une fois le jeu de données choisi, ils suivent une méthodologie rigoureuse :

1/ Exploration et analyse des données.

2/ Préparation des données.

3/ Modélisation.

4/ Évaluation.

5/ Optimisation.

6/ Interprétation.

Les projets de Machine Learning :

À titre d’exemple, voici les quelques projets sur lesquels les étudiants ont planché pendant la semaine.

Groupe 1 :

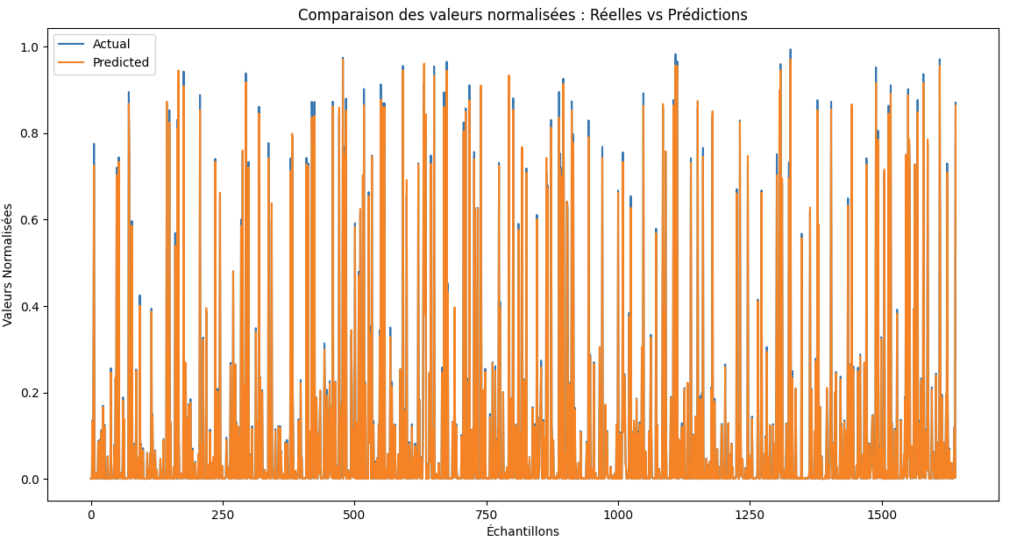

Objectif : Explorer et entraîner un modèle de données financières LSTM (Long Short-Term Memory) pour prédire les prix de clôture des actions en bourse

Groupe 2 :

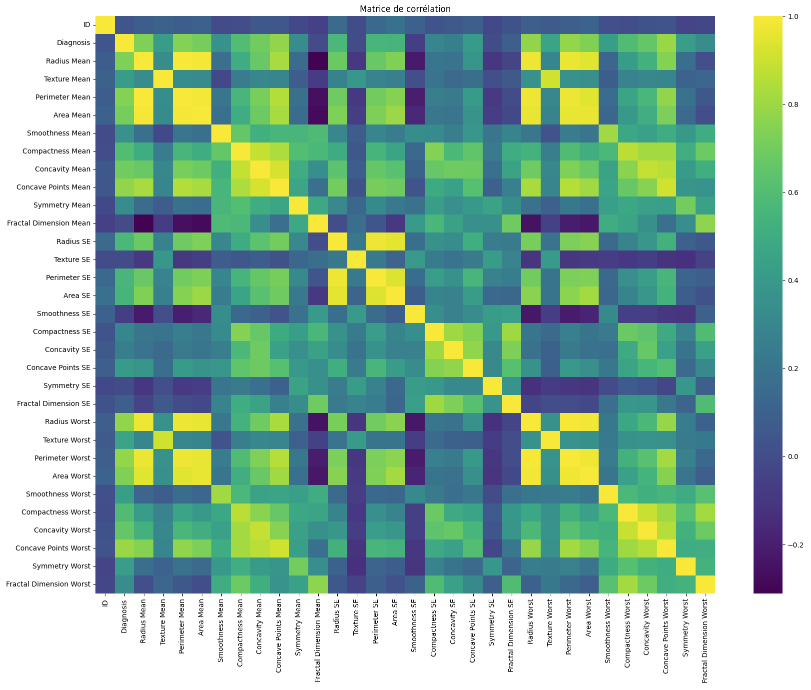

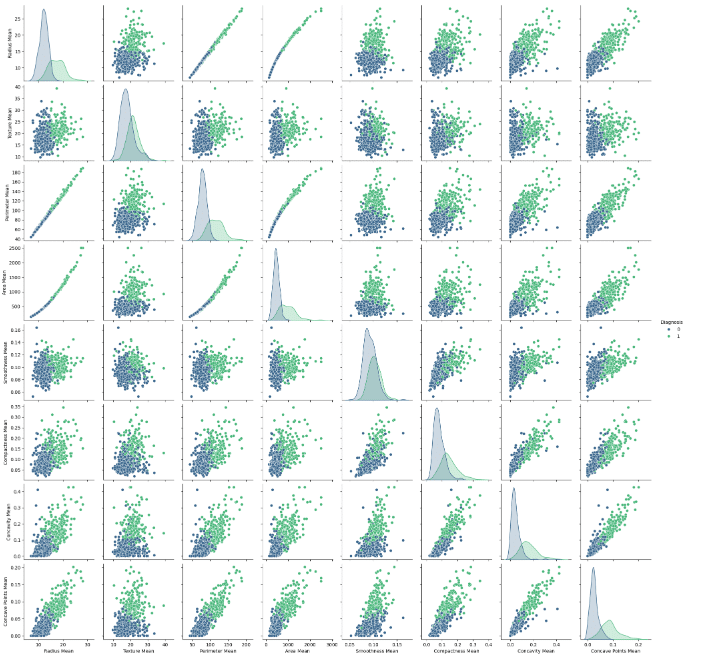

Objectif : Développer des modèles de classification pour prédire si une tumeur au sein est bénigne (non cancéreuse) ou maligne (cancéreuse). Ceci en utilisant le dataset “Breast Cancer Wisconsin (Diagnostic) Data Set” disponible sur l’UCI Machine Learning Repository.

Groupe 3 :

Objectif : Créer un modèle qui prédit la note qu’un utilisateur donnerait à un anime en fonction de sa watch list passée.

Comment évalue-t-on la qualité d’un modèle de Machine Learning ?

Pour qu’un modèle de Machine Learning soit qualitatif, il doit avoir une capacité de généralisation. Un bon modèle, c’est un modèle qui est capable de bien se comporter devant des données qu’il n’a jamais vu. En l’effet, le but d’un modèle c’est de donner des prédictions fiables.

Quels sont les défis actuels du Machine Learning ?

Les modèles existent depuis plusieurs années, toutefois le « problème » ou la limite résidaient dans la puissance de calcul. Aujourd’hui, avec le cloud et les GPUs, on n’est plus limités en termes de ressources.

En 2018, on a changé de paradigme avec les « transformers ». Un papier nommé « Attention Is All You Need » a été publié par Google et a introduit cette nouvelle notion de « transformers & self-attention » dans l’apprentissage.

Cela révolutionne la gestion de données séquentielles comme dans les textes et images et autres données de type non structurées. Le calcul devient alors linéaire et parallélisable. Ainsi, on peut entraîner les réseaux plus rapidement : ce qui prenait des mois, ne prend maintenant que quelques jours. La course a notamment démarré avec ChatGPT pour les modèles génératifs (GenAI).

Le challenge le plus récent c’est d’avoir des modèles qui arrivent à travailler sur tous types de données simultanément (textes, images, sons), ce qu’on appelle des modèles multimodaux.

Parallèlement, il apparaît des défis autour de l’éthique et de la régulation de ces modèles liés à la création de deep fakes et les manipulations massives par exemple. Aujourd’hui nous avons un cadre juridique avec “AI Act” au niveau européen.

Ecole Sup De Vinci2024-06-122024-06-13FormationQuentin Faure

Ecole Sup De Vinci2024-06-122024-06-13FormationQuentin Faure

Par Quentin Faure

Chargé de communication